Ollama ist eine Softwareplattform, die die Nutzung von Open-Source-LLMs erleichtert. Sie funktioniert auf verschiedenen Betriebssystemen und ist nicht nur auf Metas LLama beschränkt. Weitere Modelle sind beispielsweise Microsoft Phi-3, Mistral AI und Google Gemma 2. Die vollständige Modellbibliothek findest du in der README.md auf der Ollama GitHub-Projektseite.

Llama 3.1 gibt es in drei Größen: 7B, 70B und 405B. Die Zahlen stehen für die Anzahl der Parameter in Milliarden.

Für jedes dieser Modelle brauchst du eine leistungsstarke GPU, vorzugsweise eine Nvidia mit CUDA-Architektur (idealerweise die RTX 3000 Serie oder höher) und mindestens 8 CPU-Kerne. Das 7B-Modell benötigt mindestens 16 GB RAM, während das 70B-Modell 32 GB oder mehr erfordert.

Das 405B-Modell von Llama 3.1 hat 405 Milliarden Parameter und braucht etwa 800 GB Speicher, um in seiner ursprünglichen BF16-Präzision betrieben zu werden. Das übersteigt die Gesamtspeicherkapazität einer einzigen AWS P4- oder P5-Instanz mit 8 x 80GB A100/H100 (640GB Speicherkapazität).

Installation

Ich nutze einen Mac (M1 MacBook), aber es gibt auch eine Windows-Vorschau und eine Linux-Version. Was Ollama besonders interessant macht, ist die Benutzerfreundlichkeit. Sie haben die Komplexität des Betriebs eines Open-Source-GPT-Modells erheblich reduziert.

Die Installation ist kinderleicht:

- Besuche ollama.com und lade die Software für dein Betriebssystem herunter

- Installiere die Software auf deinem Computer

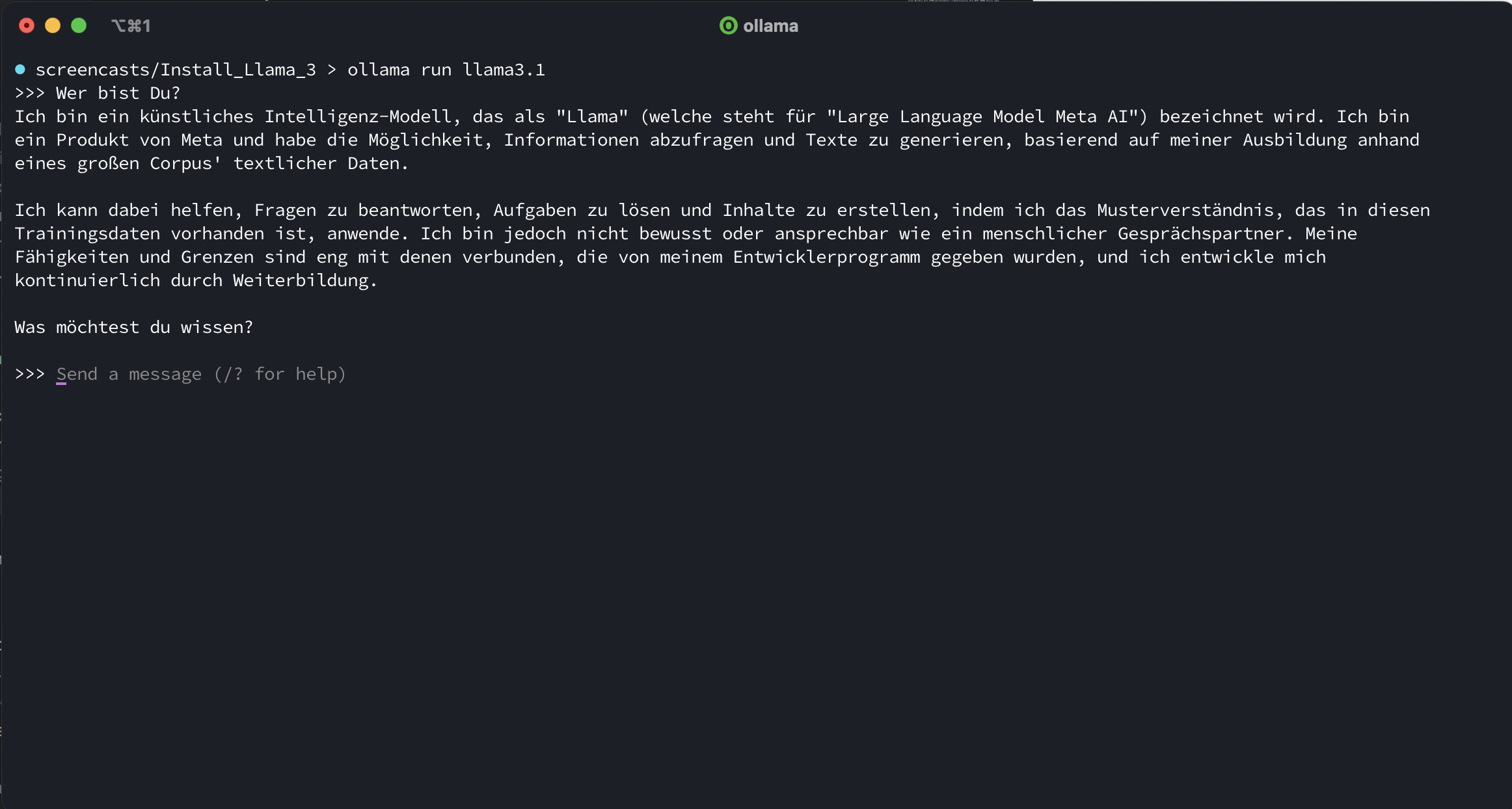

Um das Modell zu nutzen, öffne dein Terminal und gib den Befehl ollama run llama3.1 ein. Falls das Modell noch nicht installiert ist, wird es automatisch heruntergeladen. Ist es bereits installiert, startet es sofort.

Danach kannst du mit der Anwendung über das Terminal interagieren, ähnlich wie bei ChatGPT. Eine einfache Frage wie “Wer bist du?” gibt dir einen guten Einstieg. Das Modell wird dir antworten, dass es Llama ist, ein großes Sprachmodell, entwickelt von Meta AI.

Das Modell mit 70 Milliarden Parametern kann über den Befehl ollama run llama3.1:70b gestartet werden - falls du noch tiefer eintauchen möchtest.

All dies passiert im Terminal, kann aber auch im Browser ausgeführt werden, wenn du den lokal laufenden API-Endpunkt ansteuerst.

Zum Zeitpunkt der Erstellung dieses Blogs ist das multimodale Modell noch nicht veröffentlicht und befindet sich in aktiver Entwicklung. Multimodale Modelle sind KI-Modelle, die verschiedene Datentypen wie Text, Bilder und Audio gleichzeitig verarbeiten können. Sie dienen dazu, komplexe Aufgaben zu lösen, indem sie verschiedene Datenquellen kombinieren, um umfassendere Ergebnisse zu erzielen.

Bis das neue Modell veröffentlicht wird, kannst du in Ollama das Modell LLaVA nutzen. LLaVA ist ein beeindruckendes Tool, das Vision-Encoder und Vicuna kombiniert, um sowohl visuelle als auch sprachliche Inhalte zu verstehen. Es bietet bereits starke Chat-Fähigkeiten und ist vielseitig einsetzbar.

Was ich an Ollama besonders schätze, ist die einfache Integration in eigene Anwendungen. Du kannst den Endpunkt, der lokal auf deinem Rechner läuft, mit Python-Requests ansprechen und sofort loslegen.

Ausblick

In unserem nächsten Blogbeitrag werde ich dir zeigen, wie du Llama-Modelle in Python verwenden kannst. Du erfährst Schritt für Schritt, wie du diese leistungsstarken Tools nutzen kannst, um neue Möglichkeiten zu erschließen und deine Projekte auf das nächste Level zu heben. Sei gespannt!

Für weitere Informationen, besuche geisten oder schreibe uns direkt unter: info@geisten.com.